“AI 進(jìn)化史上的"USB-C時(shí)刻",2024 年? 11 月,Anthropic 發(fā)布的 MCP 協(xié)議正在引發(fā)硅谷地震。這個(gè)被喻為"AI 界 USB-C"的開放標(biāo)準(zhǔn),不僅重構(gòu)了大模型與物理世界的連接方式,更暗藏著破解 AI 壟斷困局、重構(gòu)數(shù)字文明生產(chǎn)關(guān)系的密碼。當(dāng)我們還在爭(zhēng)論 GPT-5 的參數(shù)規(guī)模時(shí),MCP 已悄然鋪就通向 AGI? 時(shí)代的去中心化之路......

Bruce:最近在研究 Model Context Protocol(MCP)。這是繼 ChatGPT 之后,在 AI 領(lǐng)域第二個(gè)讓我非常興奮的東西,因?yàn)樗邢M鉀Q我思考多年的三個(gè)問題:

非科學(xué)家和天才,普通人如何參與 AI 行業(yè)并獲得收入?

AI 和 Ethereum 有什么雙贏的結(jié)合之處?

如何實(shí)現(xiàn) AI d/acc?避免中心化的大公司壟斷、審查,AGI 毀滅人類?

01?MCP 是什么?

MCP 是一個(gè)開放標(biāo)準(zhǔn)框架,可以簡(jiǎn)化 LLM 與外部數(shù)據(jù)源和工具的集成。如果我們把 LLM 比作 Windows 操作系統(tǒng),Cursor 等應(yīng)用是鍵盤和硬件,那么 MCP 就是 USB 接口,支持將外部數(shù)據(jù)和工具靈活插入,然后用戶可以讀取使用這些外部數(shù)據(jù)和工具。

MCP 提供了三種能力對(duì) LLM 進(jìn)行擴(kuò)展:

Resources(知識(shí)擴(kuò)展)

Tools(執(zhí)行函數(shù),調(diào)用外部系統(tǒng))

Prompts(預(yù)編寫提示詞模板)

MCP 可以由任何人進(jìn)行開發(fā)和托管,以 Server 的方式提供,可以隨時(shí)下線停止服務(wù)。

02?為什么需要 MCP

目前 LLM 使用盡可能多的數(shù)據(jù)進(jìn)行大量的運(yùn)算并生成大量的參數(shù),將知識(shí)融入到模型里面,從而實(shí)現(xiàn)對(duì)話輸出相應(yīng)知識(shí)。但是存在比較大的幾個(gè)問題:

大量的數(shù)據(jù)和運(yùn)算需要大量的時(shí)間和硬件,用于訓(xùn)練的知識(shí)通常是過時(shí)的。

大量參數(shù)的模型,很難在本地設(shè)備進(jìn)行部署和使用,但實(shí)際上使用者大部分場(chǎng)景可能并不需要全部信息完成需求。

部分模型采用爬蟲的方式讀取外部信息進(jìn)行運(yùn)算以實(shí)現(xiàn)時(shí)效性,但是由于爬蟲的限制和外部數(shù)據(jù)的質(zhì)量,可能產(chǎn)出誤導(dǎo)性更強(qiáng)的內(nèi)容。

由于 AI 并沒有很好的給創(chuàng)作者帶來利益,很多網(wǎng)站和內(nèi)容開始實(shí)施反 AI 措施,生成大量垃圾信息,將會(huì)導(dǎo)致 LLM 的質(zhì)量逐步下降。

LLM 很難擴(kuò)展到方方面面的外部功能和操作,例如準(zhǔn)確調(diào)用 GitHub 接口實(shí)現(xiàn)一些操作,它會(huì)按照可能過時(shí)的文檔生成代碼,但無法確保可以精準(zhǔn)執(zhí)行。

03?胖 LLM 和瘦 LLM + MCP 的架構(gòu)演進(jìn)

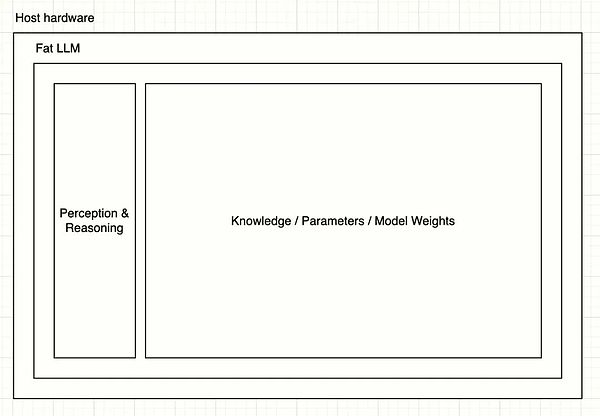

我們可以將目前的超大規(guī)模模型視為胖 LLM,其架構(gòu)可以以下面簡(jiǎn)單圖示表示:

用戶輸入信息之后,通過 Perception & Reasoning 層對(duì)輸入進(jìn)行拆解和推理,然后調(diào)用龐大的參數(shù)進(jìn)行結(jié)果生成。

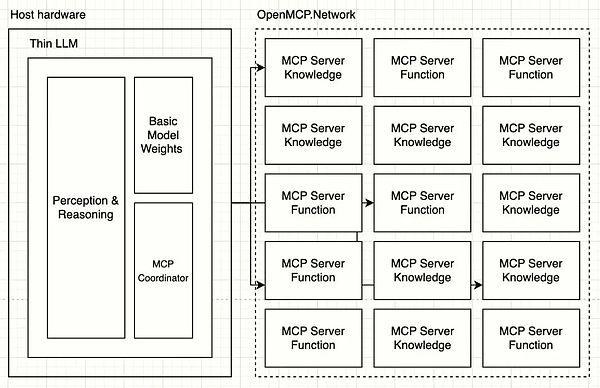

基于 MCP 之后,LLM 可能聚焦在語(yǔ)言解析本身,剝離出去知識(shí)和能力,變成瘦 LLM:

瘦 LLM 的架構(gòu)下,Perception & Reasoning 層將會(huì)關(guān)注如何將全方面的人類物理環(huán)境信息解析成為 tokens,包括但不限于:語(yǔ)音、語(yǔ)氣、氣味、圖像、文字、重力、氣溫等,然后通過 MCP Coordinator 編排和協(xié)調(diào)多達(dá)數(shù)百的 MCP Servers 完成任務(wù)。瘦 LLM 的訓(xùn)練成本和速度將會(huì)極速提升,對(duì)于部署設(shè)備的要求變得很低。

04?MCP 如何解決三大問題

普通人如何參與 AI 行業(yè)?

任何有獨(dú)特才能的人,都可以創(chuàng)建自己的 MCP Server 對(duì) LLM 提供服務(wù)。例如一個(gè)鳥類愛好者可以將自己多年的鳥類筆記通過 MCP 對(duì)外提供服務(wù)。當(dāng)有人使用 LLM 搜索跟鳥類相關(guān)的信息,就會(huì)調(diào)用到當(dāng)前鳥類筆記 MCP 服務(wù)。創(chuàng)作者也會(huì)因此獲得收入分成。

這是一種更為精準(zhǔn)和自動(dòng)化的創(chuàng)作者經(jīng)濟(jì)循環(huán),服務(wù)內(nèi)容更加標(biāo)準(zhǔn)化,調(diào)用的次數(shù)、輸出的 token 都可以很精準(zhǔn)的統(tǒng)計(jì)。LLM 提供商甚至可以同時(shí)調(diào)用多個(gè)鳥類筆記 MCP Servers 讓用戶選擇和評(píng)分來確定誰(shuí)的質(zhì)量更好獲得更高匹配權(quán)重。

AI 和 Ethereum 的雙贏結(jié)合

a. 我們可以基于 Ethereum 構(gòu)建一個(gè) OpenMCP.Network 創(chuàng)作者激勵(lì)網(wǎng)絡(luò)。MCP Server 需要托管和提供穩(wěn)定的服務(wù),用戶對(duì) LLM 提供商付費(fèi),LLM 提供商將實(shí)際的激勵(lì)通過網(wǎng)絡(luò)分配到被調(diào)用的 MCP Servers 上從而維持整個(gè)網(wǎng)絡(luò)的可持續(xù)性和穩(wěn)定性,激發(fā) MCP 的創(chuàng)作者持續(xù)創(chuàng)作和提供高質(zhì)量?jī)?nèi)容。這一套網(wǎng)絡(luò)將需要使用智能合約實(shí)現(xiàn)激勵(lì)的自動(dòng)化、透明、可信和抗審查。運(yùn)行過程中的簽名、權(quán)限驗(yàn)證、隱私保護(hù)都可以使用以太坊錢包、ZK 等技術(shù)實(shí)現(xiàn)。

b. 開發(fā) Ethereum 鏈上操作相關(guān)的 MCP Servers,例如 AA 錢包調(diào)用服務(wù),用戶將支持在 LLM 里面通過語(yǔ)言實(shí)現(xiàn)錢包付款而不暴露相關(guān)私鑰和權(quán)限給 LLM。

c. 還有各種開發(fā)者工具,進(jìn)一步簡(jiǎn)化 Ethereum 智能合約開發(fā)和代碼生成。

實(shí)現(xiàn) AI 去中心化

a. MCP Servers 將 AI 的知識(shí)和能力去中心化,任何人都可以創(chuàng)建和托管 MCP Servers,注冊(cè)到例如 OpenMCP.Network 這樣的平臺(tái)上面之后按照調(diào)用獲得激勵(lì)。沒有任何一個(gè)公司可以掌握全部的 MCP Servers。如果一個(gè) LLM 提供商給予不公平的激勵(lì)到 MCP Servers,創(chuàng)作者將支持屏蔽該公司,用戶得不到優(yōu)質(zhì)結(jié)果后將會(huì)更換其他 LLM 提供商實(shí)現(xiàn)更公平的競(jìng)爭(zhēng)。

b. 創(chuàng)作者可以對(duì)自己的 MCP Servers 實(shí)現(xiàn)細(xì)粒度的權(quán)限控制以保護(hù)隱私和版權(quán)。瘦 LLM 提供商應(yīng)該通過提供合理的激勵(lì)來讓創(chuàng)作者貢獻(xiàn)高質(zhì)量的 MCP Servers。

c. 瘦 LLM 能力差距將慢慢抹平,因?yàn)槿祟惖恼Z(yǔ)言是有遍歷上限的,演進(jìn)也很緩慢。LLM 提供商將需要把目光、資金瞄向高質(zhì)量的 MCP Servers,而非重復(fù)使用更多顯卡煉丹。

d. AGI 的能力將得到分散和降權(quán),LLM 僅作為語(yǔ)言處理和用戶交互,具體能力分布在各個(gè) MCP Servers 里面。AGI 將不會(huì)威脅到人類,因?yàn)殛P(guān)閉 MCP Servers 之后就只能進(jìn)行基礎(chǔ)語(yǔ)言對(duì)話。

05?總體回顧

LLM + MCP Servers 的架構(gòu)演進(jìn),本質(zhì)上是將 AI 能力的去中心化,降低了 AGI 毀滅人類的風(fēng)險(xiǎn)。

LLM 的使用方式,使其對(duì) MCP Servers 的調(diào)用次數(shù)和輸入輸出可以做到 token 級(jí)別的統(tǒng)計(jì)和自動(dòng)化,為 AI 創(chuàng)作者經(jīng)濟(jì)系統(tǒng)的搭建奠定了基礎(chǔ)。

好的經(jīng)濟(jì)系統(tǒng)可以驅(qū)動(dòng)創(chuàng)作者主動(dòng)貢獻(xiàn)創(chuàng)作高質(zhì)量 MCP Servers,從而帶動(dòng)整個(gè)人類的發(fā)展,實(shí)現(xiàn)正向飛輪。創(chuàng)作者不再抵御 AI,AI 也會(huì)提供更多崗位和收入,將類似 OpenAI 這樣的壟斷商業(yè)公司的利潤(rùn)合理分配。

這一套經(jīng)濟(jì)系統(tǒng),結(jié)合其特性和創(chuàng)作者的需求,非常適合基于 Ethereum 實(shí)現(xiàn)。

06?未來展望:下一步的劇本演進(jìn)

MCP 或者類 MCP 的協(xié)議將會(huì)層出不窮,幾家大公司將開始競(jìng)爭(zhēng)標(biāo)準(zhǔn)的定義。

MCP Based LLM 將會(huì)出現(xiàn),專注于解析和處理人類語(yǔ)言的小模型,附帶 MCP Coordinator 接入 MCP 網(wǎng)絡(luò)。LLM 將支持自動(dòng)發(fā)現(xiàn)和調(diào)度 MCP Servers,無需復(fù)雜手工配置。

MCP Network 服務(wù)提供商將出現(xiàn),每家有自己的經(jīng)濟(jì)激勵(lì)系統(tǒng),MCP 創(chuàng)作者將自己的 Server 注冊(cè)和托管即可得到收入。

如果 MCP Network 的經(jīng)濟(jì)激勵(lì)系統(tǒng)使用 Ethereum 構(gòu)建,基于智能合約,那么 Ethereum 網(wǎng)絡(luò)的 transactions 保守估計(jì)將增加約 150 倍(按照非常保守的每天 1 億次 MCP Servers 的調(diào)用量,目前 12s 一個(gè) Block 包括 100 txs 計(jì)算)。